Warum dein Content in LLM-Antworten erscheinen muss

Stell dir vor, du suchst nach Infos zu einem Produkt oder einer Dienstleistung – und statt durch endlose Suchergebnisse zu scrollen, bekommst du eine präzise Antwort direkt im Chat. Genau das passiert gerade in der Welt der Suchen. Ranken in LLMs wird zum Game-Changer für Unternehmen, die nicht unsichtbar werden wollen. In diesem Artikel tauchen wir ein in die Grundlagen, Unterschiede zu klassischem SEO, neue Rankingfaktoren und praktische Strategien.

Du erfährst, wie du deinen Content optimierst, um in Large Language Models (LLMs) zu ranken – von GEO-Strategien bis hin zu Monitoring und Zukunftstrends. Lass uns loslegen, warum das für deine Marke essenziell ist.

Vom Suchschlitz zum Chatfenster – die neue Nutzerreise

Früher hast du in eine Suchleiste getippt und auf blaue Links geklickt. Aber jetzt? Die Nutzerreise verändert sich rasant. Immer mehr Leute wenden sich an Chat-Interfaces, die in natürlicher Sprache antworten. Denk an Tools wie ChatGPT oder Google’s Gemini – hier fließt die Interaktion flüssig, ohne Umwege.

Von Keywords zu Konversationen: Statt stichwortbasierter Suchen stellen Nutzer volle Fragen. LLMs liefern direkte, kohärente Antworten.

Der Shift zu Zero-Click: Du bekommst Infos, ohne eine Website zu besuchen. Das spart Zeit, macht aber traditionelle SEO-Strategien teilweise obsolet.

Warum das zählt: Wenn dein Content nicht in diesen Chats auftaucht, verpasst du wertvolle Berührungspunkte mit potenziellen Kunden.

Es fühlt sich an wie ein Sprung vom alten Suchschlitz ins dynamische Chatfenster – und du musst mitmachen, um relevant zu bleiben.

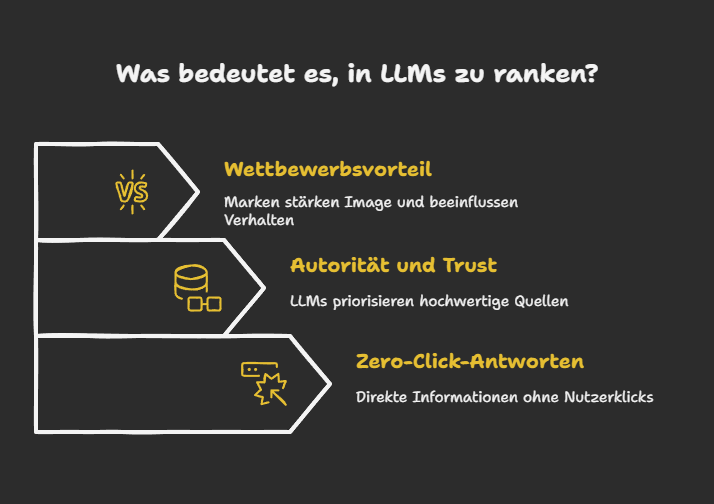

Was bedeutet „in LLMs ranken“ konkret für Unternehmen?

In LLMs zu ranken heißt, dass dein Content in den generierten KI Antworten erscheint. Das ist nicht nur nice-to-have, sondern ein Muss für Sichtbarkeit. Besonders mit LLMO (oder LLM SEO, wie es manchmal abgekürzt wird) positionierst du deine Marke als vertrauenswürdige Quelle.

Zero-Click-Antworten nutzen: Nutzer kriegen Infos direkt – wenn deine Marke zitiert wird, baust du Autorität auf, ohne Klicks.

Autorität und Trust: LLMs priorisieren faktenbasierte, hochwertige Quellen. Erscheint dein Content, signalisiert das Glaubwürdigkeit.

Wettbewerbsvorteil: Marken, die in LLM-Antworten präsent sind, stärken ihr Image und beeinflussen Nutzerverhalten positiv. Stell dir vor, deine Expertise wird als Referenz genannt – das ist unschlagbar.

Kurz gesagt, LLMO sorgt dafür, dass du nicht im Hintergrund verschwindest. Es geht um direkte Präsenz in der KI-gestützten Welt, wo Nutzer schnelle, zuverlässige Infos erwarten. Und hey, es kann überwältigend wirken, aber mit den richtigen Schritten bist du vorn dabei.

Tauchen wir nun tiefer in die technischen Aspekte ein. Wie genau LLMO und GEO deine Content-Strategie verbessern können, ist entscheidend, um auf dieser neuen Suchbühne erfolgreich zu sein.

Klassische SEO vs. LLMO vs. GEO: Was du über SEO-Strategien für LLMs wissen musst

In der Welt der Suchmaschinenoptimierung (SEO) gibt es seit Jahren ein bekanntes Ziel: Höhere Platzierungen in den traditionellen Suchergebnissen. Doch mit dem Aufkommen von Large Language Models (LLMs), wie ChatGPT, und deren Integration in die Suchlandschaft verändert sich das Spiel.

In diesem Kapitel klären wir, was es bedeutet, „in LLMs zu ranken“, und wie sich klassische SEO, LLMO (Large Language Model Optimization) und GEO (Generative Engine Optimization) voneinander unterscheiden und ergänzen.

Klassische SEO: Der Weg über Keywords und Links

Klassische SEO ist das, was die meisten von uns kennen. Es konzentriert sich auf die Optimierung von Websites, um in den traditionellen Suchmaschinen wie Google, Bing oder Yahoo besser platziert zu werden. Wichtige Faktoren hier sind:

Keywords : Die gezielte Verwendung von Schlüsselwörtern, die Nutzer bei der Suche eingeben.

Backlinks: Verweise von anderen Websites, die die Autorität und Relevanz der eigenen Seite erhöhen.

On-Page-Optimierung: Optimierung von Titeln, Meta-Beschreibungen, Texten und Bildern, um sie für Suchmaschinen besser verständlich zu machen.

Technische SEO: Die Optimierung der Ladegeschwindigkeit, mobilen Anpassung und strukturierten Daten.

Klassische SEO dreht sich also um die Sichtbarkeit in den traditionellen organischen Suchergebnissen, die Nutzer anziehen und auf die Website leiten.

LLMO: Optimierung für Large Language Models

LLMO (Large Language Model Optimization) bezeichnet die Optimierung von Inhalten für die Antworten von generativen Sprachmodellen, wie sie in modernen KI-Chat-Interfaces verwendet werden. Im Unterschied zur klassischen SEO geht es bei LLMO nicht mehr um die Auffindbarkeit in den Suchergebnissen von Google, sondern darum, dass dein Content in den Antworten von Sprachmodellen wie ChatGPT oder Google Gemini erscheint.

Wichtige Punkte bei LLMO:

Faktenbasierte Inhalte : LLMs bevorzugen klare, präzise und faktenbasierte Informationen. Inhalte müssen also strukturierte, verlässliche Daten enthalten.

Semantische Klarheit: LLMs „verstehen“ Inhalte durch semantische Beziehungen und nicht nur durch Keywords. Das bedeutet, dass kontextuelle Relevanz wichtiger ist als die bloße Häufung von Suchbegriffen.

Autorität und Trust: LLMs nutzen signifikante Quellen, um Vertrauen aufzubauen und Quellen zu zitieren. Daher ist es entscheidend, Inhalte so zu gestalten, dass sie als vertrauenswürdige Quelle wahrgenommen werden.

GEO: Generative Engine Optimization – Das neue SEO

GEO (Generative Engine Optimization) ist ein aufkommender Trend, der mit LLMs und generativen AI-Technologien eng zusammenhängt. GEO geht über die reine Optimierung von Inhalten hinaus und berücksichtigt, wie KI-Modelle selbst Inhalte generieren und strukturieren. Die Zielsetzung ist es, deine Inhalte so zu optimieren, dass sie von generativen Engines (wie GPT-3, GPT-4 oder ähnlichen Technologien) genutzt und in deren Ausgaben integriert werden.

Themenclustering: In GEO wird der Fokus auf thematisch verbundene Inhalte gelegt, die LLMs helfen, Zusammenhänge besser zu verstehen.

Verwendung von Semantik und Kontext: GEO fördert die semantische Vernetzung von Inhalten, sodass LLMs die Struktur deines Contents leichter erfassen können.

Automatische Antwortgenerierung: GEO unterstützt die Generierung von Inhalten, die direkt in den Antworten der KI genutzt werden können. Dazu gehören prägnante Snippets, die in generativen Antworten auftauchen.

Gemeinsamkeiten und Unterschiede zwischen LLMO und GEO

Aspekt | LLMO | GEO |

Zielsetzung | Sichtbarkeit in KI-generierten Antworten durch präzise Zitation und Verwendung | Optimierung der generativen Fähigkeit von LLMs, damit diese Informationen erstellen |

Inhaltliche Ausrichtung | Optimierung von Inhalten für die Zitation durch LLMs | Beeinflussung, wie Inhalte automatisch generiert und formatiert werden |

Optimierungsfokus | Präzision und Relevanz im Zusammenhang mit den Modellen | Fokus auf die Erstellung semantisch vernetzter und tiefgehender Inhalte für generative KI-Modelle |

Semantische Klarheit | Inhalte müssen klar strukturiert und für LLMs verständlich sein | Inhalte müssen semantisch vernetzt und in einer Art präsentiert werden, die die KI beim Generieren unterstützt |

Wie LLMs Quellen finden und zitieren

LLMs basieren auf probabilistischen Modellen, um musterbasierte Antworten zu generieren. Sie durchforsten riesige Datensätze und wählen dann die relevantesten, semantisch kohärentesten Quellen aus. Anders als traditionelle Suchmaschinen, die Keywords und Links nutzen, um Inhalte zu bewerten, berücksichtigen LLMs:

Strukturierte und klar formulierte Inhalte: LLMs bevorzugen Inhalte, die logisch und kohärent gegliedert sind. Verwende also Überschriften, Aufzählungen und klar definierte

Absätze, die eine schnelle Analyse durch die KI ermöglichen.

Verlässliche Quellen: Inhalte, die verlässliche Quellen zitieren und dokumentieren, haben eine höhere Chance, in den KI-generierten Antworten zitiert zu werden. Die Quellen können wissenschaftliche Referenzen, Studien oder anerkannte Expertenmeinungen umfassen.Aktualität und Relevanz: LLMs bevorzugen aktualisierte Inhalte, die mit den neuesten Trends und Fakten übereinstimmen. Dies signalisiert den Modellen, dass der Inhalt vertrauenswürdig und relevant ist.

Abschließend lässt sich sagen, dass LLMO (Large Language Model Optimization) am besten geeignet ist, um das Thema „Wie man in LLMs rankt?“ zu beschreiben, da es speziell auf die Optimierung von Inhalten für die Sichtbarkeit und Zitierung in KI-gesteuerten Antworten abzielt und so direkt auf die Bedürfnisse und Herausforderungen eingeht, die mit der Präsenz in generierten Antworten von LLMs verbunden sind.

Nun, da du weißt, wie du deinen Content für LLMs und GEO optimieren kannst, schauen wir uns die neuen Rankingfaktoren an. Es ist wichtig zu verstehen, welche Faktoren den Unterschied ausmachen, damit dein Content in den Antworten von LLMs wirklich glänzen kann.

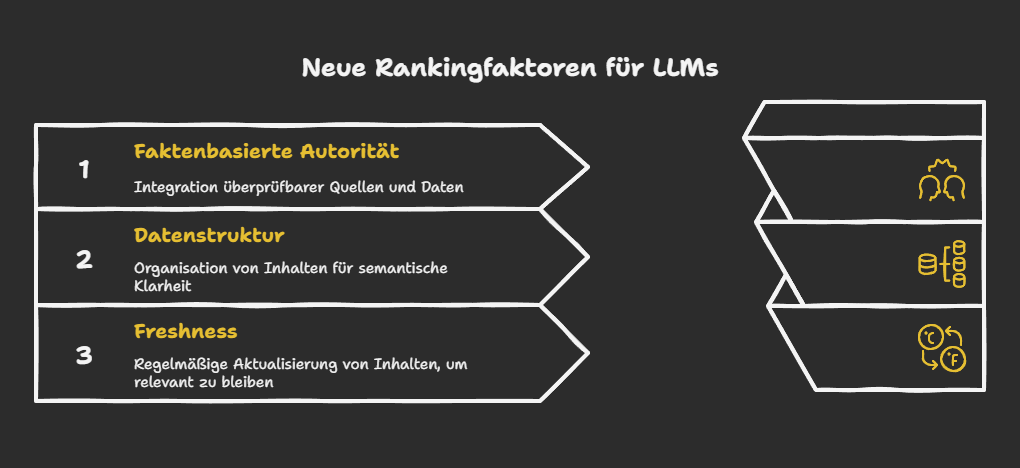

Neue Rankingfaktoren für LLMs: Was du über Autorität und Relevanz wissen musst

Stell dir vor, du optimierst deinen Content für LLMO – aber was zählt wirklich, um in den Antworten von Large Language Models aufzutauchen? Hier verschieben sich die Prioritäten. Weg von reinen Backlinks hin zu Faktoren, die auf Glaubwürdigkeit und Klarheit setzen.

Lass uns das aufschlüsseln, damit du direkt umsetzen kannst. Es geht um faktenbasierte Autorität, strukturierte Daten und Frische – alles entscheidend für LLMO-Erfolge.

Faktenbasierte Authority & Trust-Signale

LLMs lieben Inhalte, die auf soliden Fakten beruhen. Du weißt schon, wie wichtig Vertrauen ist? Genau das wird hier zum Game-Changer. Wenn dein Content überprüfbare Quellen, verifizierte Daten und zitierfähige Infos bietet, steigt deine Chance, zitiert zu werden. Denk dran: Autorität entsteht durch Expertise – wie wissenschaftliche Referenzen oder Expertenmeinungen.

Glaubwürdige Quellen priorisieren: Integriere Links zu etablierten Sites wie Wikipedia oder Studien, um Trust aufzubauen.

Konsistente Fakten liefern: Aktualisiere Infos regelmäßig, damit LLMs deine Inhalte als zuverlässig einstufen.

Externe Signale nutzen: Sammle Erwähnungen von vertrauenswürdigen Plattformen, die deine Autorität untermauern.

So baust du eine starke Basis für LLMO auf. Es fühlt sich manchmal überwältigend an, oder? Aber fang klein an – mit einer Handvoll starker Referenzen machst du schon den Unterschied.

Datenstruktur & semantische Klarheit

Hier kommt’s auf die Struktur an. LLMs scannen Inhalte semantisch, also hilft eine klare Aufbauweise enorm. Vergiss nicht: Je logischer dein Text organisiert ist, desto besser wird er in Antworten integriert. Das ist LLMO pur – optimiert für Maschinen, die wie Menschen „denken“.

Präzise Headings verwenden: Strukturiere mit klaren Überschriften, die den Inhalt logisch gliedern.

Schema Markup einsetzen: Tools wie Schema.org machen deinen Content maschinenlesbar.

Mehrdeutigkeiten vermeiden: Schreib klar und betone den Wert, damit LLMs den Kern erfassen.

Probier’s aus – ein gut strukturierter Artikel kann deine Sichtbarkeit in Chats verdoppeln. Und hey, es ist einfacher, als es klingt, wenn du Schritt für Schritt vorgehst.

Freshness & Modell-Updates

Frischer Content ist King in der Welt der LLMs. Diese Modelle werden ständig upgedatet, also musst du mitziehen. Aktualisiere deine Inhalte regelmäßig, um relevant zu bleiben. Das sorgt dafür, dass deine Infos mit dem neuesten Wissensstand matchen – ein Muss für effektives LLMO.

Regelmäßige Updates planen: Setz einen Kalender für Content-Refreshs, passend zu Modell-Updates wie bei OpenAI.

Trends einbauen: Integriere aktuelle Entwicklungen, um Frische zu signalisieren.

Relevanz steigern: Passe Inhalte an, damit sie im Wettbewerb glänzen und öfter zitiert werden.

Es kann tricky sein, immer auf dem Laufenden zu bleiben… Aber stell dir vor, dein Content taucht in jeder relevanten Antwort auf – das ist der Lohn. Fang mit deinen Top-Seiten an und baue von da aus.

Nachdem wir nun die wichtigsten Rankingfaktoren besprochen haben, wollen wir uns anschauen, wie du mit cleveren GEO-Strategien deinen Content so strukturieren kannst, dass er die beste Chance hat, von LLMs als wertvolle Quelle zitiert zu werden.“

Möchtest du mehr darüber erfahren, wie du mit den neuesten Rankingfaktoren und Technologien wie GEO in den Antworten von LLMs sichtbar wirst?

Unser SEO Automaten PRO hilft dir, deine Content-Strategie nicht nur für traditionelle SEO, sondern auch für die Welt der KI-gestützten Suchen zu optimieren. Entdecke, wie du durch präzise und gezielte Automatisierungen deine Rankings auf das nächste Level hebst.

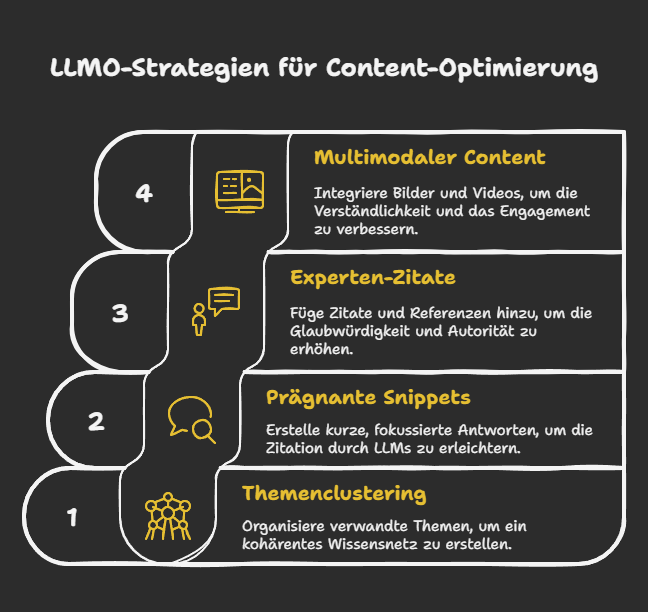

LLMO-Strategien für Content-Optimierung: Wie du deine Inhalte für LLMs sichtbarer machst

Stell dir vor, dein Content ist so gut vorbereitet, dass LLMs ihn automatisch als Top-Quelle wählen – klingt traumhaft, oder? In diesem Abschnitt tauchen wir in GEO-Strategien ein, die dir helfen, deinen Content für LLMO zu optimieren. Es geht um clevere Ansätze, die über klassisches SEO hinausgehen und direkt auf die Bedürfnisse von Sprachmodellen abzielen.

Wir schauen uns an, wie du Themen clustern, präzise Snippets basteln und mehr kannst, um in LLMO ganz vorne mitzuspielen. Lass uns loslegen, es ist einfacher, als du denkst.

Themenclustering und Deep-Content

Du weißt, wie wichtig Struktur ist, wenn du Inhalte für Suchmaschinen optimierst. Bei LLMO geht’s aber noch einen Schritt weiter. Themenclustering bedeutet, verwandte Themen zu bündeln, und Deep-Content sorgt für Tiefe, die LLMs lieben. So baust du ein kohärentes Wissensnetz auf, das Modelle leicht verstehen und zitieren können.

Warum das funktioniert? LLMs scannen nach semantischen Zusammenhängen – und eine klare Gliederung macht’s ihnen leicht. Hier ein paar Tipps, wie du das umsetzt:

Cluster deine Themen: Gruppiere ähnliche Inhalte um ein Kernkeyword wie „LLMO“ herum. Zum Beispiel: Ein Hauptartikel zu LLM-Optimierung mit Links zu Unterthemen wie RAG-Integration oder Trust-Signalen.

Geh in die Tiefe: Schreib ausführliche Guides, die nicht nur oberflächlich bleiben. Nutze Unterüberschriften, um Abschnitte logisch zu gliedern – das hilft LLMs, Kontext zu greifen.

Halte es kohärent: Vermeide Sprünge; baue logische Brücken zwischen Abschnitten. So wirkt dein Content wie ein zuverlässiger Experte.

In meiner Erfahrung macht das den Unterschied: Dein Content fühlt sich nicht nur für Leser, sondern auch für Algorithmen wie eine echte Autorität an.

Prägnante Answer Snippets erstellen

LLMs generieren oft knappe Antworten – und genau da solltest du ansetzen. Prägnante Answer Snippets sind wie kleine Goldnuggets in deinem Content, die direkt auf Fragen eingehen. Das steigert die Chance, dass dein Material in LLMO zitiert wird, ohne dass User weiterklicken müssen.

Es kann overwhelming wirken, aber fang klein an. Hier eine kurze Anleitung, um solche Snippets zu craften:

Identifiziere gängige Fragen: Nutze Tools wie Ahrefs oder Google Trends, um zu sehen, was User fragen.

Formuliere direkt: Antworte in 1-2 Sätzen oder Bullet Points. Beispiel: „Was ist LLMO? Es optimiert Content für Large Language Models, um in KI-generierten Antworten zu ranken.“

Integriere sie natürlich: Platziere Snippets am Anfang von Abschnitten oder in FAQs – so sind sie leicht zugänglich.

Probier’s aus, und du wirst sehen: Diese Snippets machen deinen Content snackable und LLM-freundlich. Es ist, als würdest du dem Modell die Arbeit abnehmen – genial, oder?

Experten-Zitate & wissenschaftliche Referenzen

Trust ist King in der Welt von LLMO. Indem du Experten-Zitate und wissenschaftliche Referenzen einbaust, signalisierst du Verlässlichkeit. LLMs priorisieren Quellen, die autoritär wirken, besonders in sensiblen Themen.

Wir alle wissen, wie skeptisch User gegenüber KI-Antworten sein können – da helfen echte Expertenstimmen. So machst du’s:

Finde authentische Zitate: Interviewe Branchenführer oder zitiere aus Studien von Orten wie arXiv.

Verlinke Quellen: Füge Footnotes oder Links ein, um Glaubwürdigkeit zu boosten – das lieben LLMs.

Integriere sie smooth: Lass Zitate nahtlos in den Text fließen, nicht wie Fremdkörper. Beispiel: „Wie SEO-Experte John Mueller sagt: ‚Content muss trustwürdig sein, um zu ranken‘.“

Das baut nicht nur Trust auf, sondern macht deinen Content unvergesslich. Es fühlt sich an wie ein Gespräch mit Profis – und das merkt man in den Rankings.

Multimodaler Content für gemischte LLMs

Text allein reicht nicht mehr aus; multimodale Inhalte mit Bildern, Videos oder Infografiken machen den Unterschied. Besonders für gemischte LLMs, die visuelle Daten verarbeiten, wird das essenziell in LLMO.

Stell dir vor, dein Artikel erklärt etwas Komplexes mit einer Infografik – das ist Gold für LLMs, die ganzheitliche Antworten bauen. Hier Tipps, um multimodal zu gehen:

Mische Formate: Ergänze Text mit Grafiken oder Videos von Plattformen wie YouTube.

Optimiere für Zugänglichkeit: Füge Alt-Texte und Beschreibungen hinzu, damit LLMs alles erfassen können.

Erhöhe Dichte: Visuelle Elemente verdichten Infos – ideal für zero-click-Szenarien, wo LLMs schnelle Einblicke brauchen.

Es ist fast wie Magie: Dein Content wird reicher, und LLMs greifen lieber darauf zurück. Probier’s, und du siehst, wie es deine Sichtbarkeit pusht.

Nachdem wir nun die GEO-Strategien und deren Anwendung betrachtet haben, werfen wir einen Blick auf die technische Umsetzung und wie du Monitoring und Erfolgsmessung nutzen kannst, um deinen Fortschritt zu tracken und deine Strategie anzupassen.

GEO-Strategien sind entscheidend, um deinen Content für LLMs perfekt zu strukturieren.

Wenn du die automatisierte Erstellung von relevantem Content mit den besten GEO-Optimierungen kombinieren möchtest, könnte unser Content Automaten der richtige Ansatz für dich sein. Lass uns gemeinsam an deiner Content-Strategie arbeiten und die richtigen Themenclustering-Strategien für mehr Sichtbarkeit implementieren.

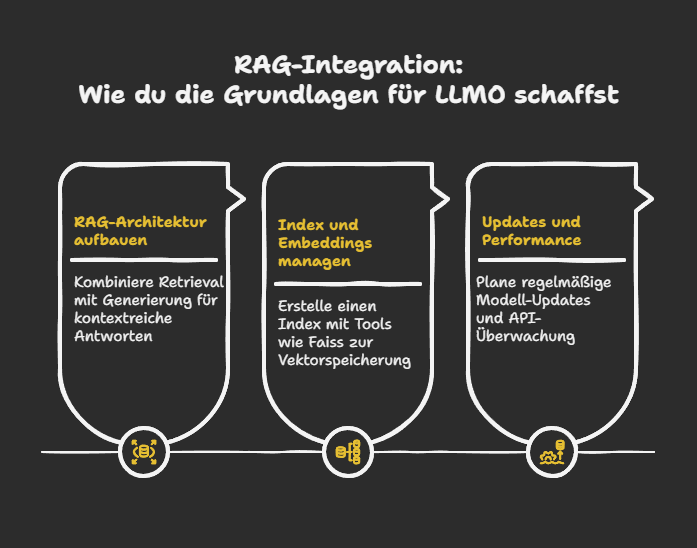

Technische Umsetzung und RAG-Integration: Wie du die Grundlagen für LLMO schaffst

Du fragst dich vielleicht, wie du LLMO technisch umsetzt, um deine Inhalte optimal in Large Language Models (LLMs) zu positionieren. Es geht hier um die praktische Seite – von strukturierten Daten bis hin zu fortschrittlichen Integrationen. Lass uns das Schritt für Schritt betrachten. Diese Elemente sind entscheidend, um deine Marke in LLM-Antworten sichtbar und vertrauenswürdig zu machen. Denk dran, LLMO ist nicht nur Theorie; es braucht einen soliden technischen Unterbau.

Structured Data, APIs & Embeddings

Stell dir vor, du baust eine Brücke zwischen deinem Content und dem LLM – das ist der Kern der technischen Umsetzung. Mit strukturierten Daten wie Schema-Markup gibst du dem Modell klare Hinweise, was dein Inhalt bedeutet. Es ist wie ein semantisches Etikett, das Missverständnisse vermeidet. Aber hey, es geht noch weiter.

APIs sorgen für den nahtlosen Fluss: Sie verbinden dein CMS oder deine Datenbank direkt mit dem LLM, damit immer frische Infos abrufbar sind. Und dann kommen Embeddings ins Spiel – diese wandeln deinen Text in Vektoren um, die Ähnlichkeiten blitzschnell erkennen. So wird LLMO effizienter, weil relevante Teile deines Contents präzise gefunden werden.

Strukturierte Daten einsetzen: Verwende Schema.org-Markup, um deinen Content semantisch zu bereichern und die Verständnisrate in LLMs zu boosten.

API-Integration: Stelle sicher, dass Updates in Echtzeit über APIs fließen – das hält deinen Inhalt aktuell und relevant für LLMO-Strategien.

Embeddings nutzen: Konvertiere Texte in Vektoren für schnelle, semantische Suchen; Tools wie Faiss können hier hilfreich sein, um Indizes zu bauen.

Diese Kombination minimiert Fehler und macht deinen Content für LLMs unwiderstehlich. Es fühlt sich manchmal kompliziert an, oder? Aber mit der richtigen Einrichtung läuft es wie am Schnürchen.

Retrieval Augmented Generation im eigenen Stack

Jetzt zum spannenden Teil: Retrieval Augmented Generation (RAG) in deinem eigenen System. RAG ist wie ein Turbo für LLMs – es holt relevante Infos aus einem Index und integriert sie in die Generierung. Das reduziert Halluzinationen, du weißt schon, diese erfundenen Fakten, die Modelle manchmal ausspucken. Für LLMO bedeutet das: Deine Antworten werden faktenbasiert und vertrauenswürdig.

Im eigenen Stack baust du das auf, indem du einen embedding-basierten Index erstellst. Regelmäßige Updates sorgen für Frische, und ein starkes API-Setup hält alles am Laufen. Es ist eine smarte Art, deine Inhalte dynamisch zu machen, besonders in einem Feld wie LLMO, wo Genauigkeit zählt.

RAG-Architektur aufbauen: Kombiniere Retrieval mit Generierung, um kontextreiche Antworten zu erzeugen – ideal für höhere Relevanz in LLM-Antworten.

Index und Embeddings managen: Erstelle einen Index mit Tools wie Faiss, der deine Inhalte in Vektoren speichert und schnell abruft.

Updates und Performance: Plane regelmäßige Modell-Updates und API-Überwachung, um Faktentreue zu gewährleisten und Halluzinationen zu vermeiden.

Am Ende stärkt RAG nicht nur deine Sichtbarkeit, sondern auch die Glaubwürdigkeit. Es kann überwältigend wirken, aber fang klein an – die Vorteile für dein LLMO sind enorm. Imagine, deine Marke taucht immer öfter in Chat-Antworten auf, weil alles technisch perfekt abgestimmt ist.

Nun, da du die technischen Grundlagen für eine erfolgreiche LLMO-Strategie kennst, wollen wir uns der letzten entscheidenden Ebene zuwenden: Content-Promotion und externe Signale. Denn auch die beste Content-Strategie braucht Unterstützung von außen, um wirklich sichtbar zu werden.

Die perfekte technische Umsetzung ist der Schlüssel für eine erfolgreiche LLMO-Strategie.

Unsere KI Automation bietet dir maßgeschneiderte Lösungen, um deine Content-Optimierung für LLMs, RAG-Integrationen und alles, was du benötigst, zu automatisieren. Wenn du schnellere, skalierbare und präzisere Ergebnisse erzielen möchtest, ist es Zeit, in KI-basierte Automationen zu investieren.

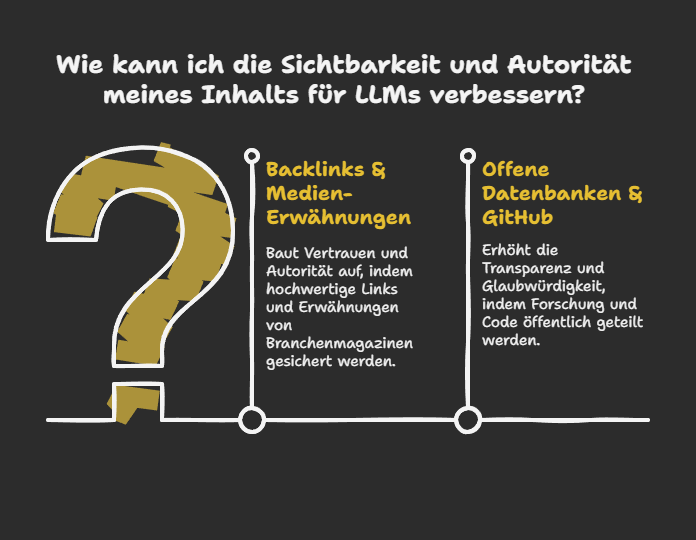

Content-Promotion und externe Signale: Warum Backlinks und Medien-Erwähnungen in LLMs zählen

Stell dir vor, dein Content ist super, aber ohne externe Unterstützung bleibt er unsichtbar – wie ein Diamant im Dunkel. Bei LLMO geht es nicht nur um den Inhalt selbst, sondern auch darum, ihn durch smarte Promotion und Signale zu boosten. Externe Faktoren wie Backlinks und Erwähnungen machen deinen Content für Large Language Models (LLMs) unwiderstehlich.

Lass uns das genauer anschauen, damit du deine Strategie direkt anpassen kannst. Es ist einfacher, als du denkst, und bringt enorme Vorteile für deine Marke.

Backlinks & Mentions in Fachmedien

Backlinks sind wie Empfehlungen von alten Freunden – sie bauen Vertrauen auf. In der Welt von LLMO signalisieren hochwertige Links, dass dein Content autoritär und relevant ist. LLMs wie ChatGPT oder Gemini scannen nicht nur den Text, sondern achten auf diese externen Validierungen, um Quellen zu priorisieren. Und hey, es ist normal, wenn du dich fragst: Wie baue ich das auf? Ganz einfach, fang mit Gastbeiträgen in Branchenmagazinen an. Das stärkt nicht nur dein Ranking in LLMO, sondern positioniert dich als Thought Leader.

Gezieltes Linkbuilding: Konzentriere dich auf qualitativ hochwertige Backlinks von renommierten Sites. Ein Link von einer Fachpublikation wie Search Engine Journal kann Wunder wirken, da LLMs solche Quellen als vertrauenswürdig einstufen.

Erwähnungen in Medien: Strebe nach Features in Branchenportalen. Wenn dein Content in Artikeln zitiert wird, steigt seine Glaubwürdigkeit – LLMs lieben das, weil es wie eine unabhängige Bestätigung wirkt.

Strategische Kooperationen: Arbeite mit Influencern oder Experten zusammen. Eine Erwähnung in einem Podcast oder Blog kann deine LLMO Sichtbarkeit explodieren lassen, ohne dass es übertrieben aufwendig ist.

Am Ende des Tages… diese Signale machen den Unterschied. Sie sorgen dafür, dass dein Content nicht nur gefunden, sondern auch zitiert wird. Probier’s aus – es lohnt sich!

Offene Datenbanken & GitHub als Trust-Quelle

Offene Datenbanken sind der neue Hotspot für LLMO. Warum? Weil LLMs transparente, verifizierbare Quellen priorisieren. Plattformen wie GitHub dienen als Beweis für deine Expertise – denk an Code-Snippets oder Datensätze, die deine Inhalte untermauern. Es ist, als würdest du deine Hausaufgaben zeigen, und die Modelle belohnen das mit höherer Sichtbarkeit. Hast du schon mal überlegt, deine Recherche-Daten öffentlich zu machen? Das könnte dein Game-Changer sein.

Publiziere auf GitHub: Lade Supporting-Daten hoch, wie Statistiken oder Algorithmen. LLMs greifen darauf zurück, weil es authentisch und zugänglich ist – perfekt für LLMO Optimierung.

Offene Datenbanken nutzen: Integriere Plattformen wie Kaggle oder Wikidata. Das schafft zusätzliche Vertrauenssignale und macht deinen Content für Modelle attraktiver.

Transparenz als Vorteil: Teile Quellen offen, um Glaubwürdigkeit aufzubauen. Es signalisiert LLMs, dass du zuverlässig bist, was zu besseren Rankings in generierten Antworten führt.

Zusammengefasst: Baue ein Netzwerk aus externen Signalen auf, und deine Inhalte werden in LLM-Antworten strahlen. Es ist kein Hexenwerk, sondern eine clevere Ergänzung zu deiner Content-Strategie – fang heute an!

Nachdem du nun weißt, wie du externe Signale effektiv nutzen kannst, um deine LLMO-Strategie zu unterstützen, schauen wir uns die Monitoring-Methoden und KPIs an, mit denen du den Erfolg deiner Optimierungen messen kannst.

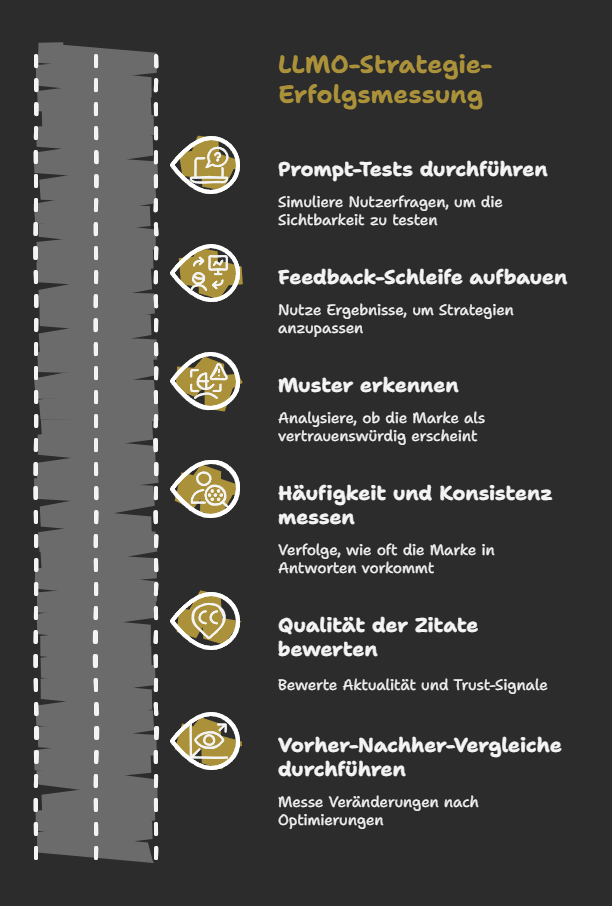

Monitoring und Erfolgsmessung: Wie du den Erfolg deiner LLMO-Strategie überprüfst

Stell dir vor, du hast all die harte Arbeit in deine LLMO-Strategie gesteckt – aber wie weißt du, ob es wirklich funktioniert? Genau hier kommt das Monitoring ins Spiel. Es geht darum, deine Sichtbarkeit in den Antworten von Large Language Models (LLMs) zu überprüfen und zu messen.

Lass uns das Schritt für Schritt durchgehen, damit du deine Fortschritte tracken und anpassen kannst. Es ist wie ein Check-up für deinen Content: Regelmäßig und ehrlich, um langfristig vorne zu bleiben.

Prompt-Testing: Taucht mein Brand im Chat auf?

Das Herzstück deiner Erfolgsmessung ist das Prompt-Testing. Du simulierst einfach Nutzerfragen, die deine Zielgruppe stellen könnte, und schaust, ob dein Brand oder Content in den LLM-Antworten auftaucht. Es fühlt sich ein bisschen an wie Detektivarbeit, oder? Aber es ist essenziell, um zu sehen, ob deine Optimierungen greifen.

Regelmäßige Tests durchführen:

Probiere verschiedene Prompt-Varianten aus – von einfachen Fragen bis zu komplexen Szenarien. Vergleiche, wie oft dein Content zitiert wird.Feedback-Schleife aufbauen:

Nutze die Ergebnisse, um bei Modell-Updates oder Content-Änderungen schnell zu reagieren. Ein kontinuierlicher Prozess hält dich auf dem Laufenden.Erkenne Muster:

Achte darauf, ob deine Marke als vertrauenswürdige Quelle erscheint. Das zeigt, ob LLMO wirklich wirkt.

Und hey, es kann frustrierend sein, wenn es nicht sofort klappt – wir alle kennen das. Aber mit der Zeit siehst du klare Verbesserungen.

KPI-Set für LLM-Sichtbarkeit

Ohne messbare Ziele tappst du im Dunkeln. Deshalb brauchst du ein solides KPI-Set, das speziell auf LLMO abgestimmt ist. Es geht nicht nur um Zahlen, sondern auch um die Qualität deiner Präsenz in den Zero-Click-Antworten.

Häufigkeit und Konsistenz:

Zähle, wie oft deine Marke in LLM-Antworten vorkommt. Ist es stabil über verschiedene Prompts hinweg?Qualität der Zitate:

Bewerte Aktualität und Trust-Signale – sind die Fakten frisch und autoritär?Vorher-Nachher-Vergleiche:

Messe Veränderungen nach Optimierungen. Hat sich die Sichtbarkeit verbessert?

Diese KPIs decken quantitative und qualitative Aspekte ab. Denk dran, sie anzupassen, je nach deinem Business. So wird LLMO nicht nur eine Theorie, sondern ein greifbarer Erfolg. Und falls du Tools wie ChatGPT für Tests nutzt, integriere sie nahtlos in deine Routine.

Zusammenfassend: Bleib dran am Monitoring, passe an und sieh zu, wie deine LLMO-Bemühungen Früchte tragen. Es ist ein dynamischer Prozess, der dir hilft, in der Welt der Chatfenster nicht unterzugehen.

Zum Abschluss dieses Artikels wollen wir dir noch einmal die wichtigsten Schritte und Empfehlungen mit auf den Weg geben, damit du deine LLMO-Strategie erfolgreich umsetzt und langfristig sichtbar bleibst.

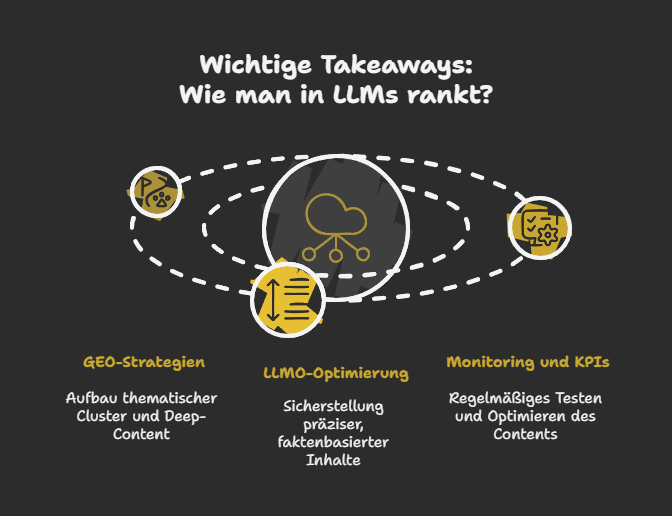

Fazit: GEO als Schlüssel zur Sichtbarkeit in LLM-Antworten – Deine nächste Schritt-für-Schritt-Strategie

Nach dem Durchlesen dieses Artikels solltest du nun klar verstehen, wie wichtig es ist, deinen Content auf die Bedürfnisse von Large Language Models (LLMs) auszurichten. Die Suche hat sich verändert, und LLMO (Large Language Model Optimization) sowie GEO (Generative Engine Optimization) sind jetzt der Schlüssel, um deine Sichtbarkeit in der neuen Ära der KI-gesteuerten Antworten zu sichern.

Warum du jetzt handeln solltest:

Die Präsenz in KI-gestützten Suchergebnissen ist kein Zukunftstrend mehr – sie ist jetzt entscheidend für deinen Erfolg. Wenn du deinen Content für LLMs optimierst, öffnest du dir Türen zu Zero-Click-Antworten, die dir nicht nur Sichtbarkeit, sondern auch Vertrauen und Autorität verschaffen. GEO und LLMO sind keine nice-to-have Strategien, sondern der nächste Schritt in der Zukunft der Suchmaschinenoptimierung.

Wichtige Takeaways, um direkt loszulegen:

GEO-Strategien nutzen : Baue thematische Cluster und Deep-Content, der LLMs hilft, deine Expertise zu verstehen und zu nutzen.

LLMO-Optimierung vorantreiben: Sorge dafür, dass dein Content durch präzise, faktenbasierte Inhalte und eine klare Struktur die Trust-Signale erhält, die LLMs lieben.

Monitoring und KPIs: Teste regelmäßig, ob dein Content in KI-Antworten auftaucht, und optimiere kontinuierlich auf Basis von Feedback.

Der Weg zu mehr Sichtbarkeit in LLMs ist klar:

Indem du GEO und LLMO als Kern deiner Content-Strategie etablierst, baust du nicht nur für die Zukunft vor, sondern positionierst deine Marke als Autorität in der KI-Ära. Es ist die perfekte Kombination aus traditionellem SEO, semantischer Klarheit und generativer KI, die deine Sichtbarkeit auf das nächste Level hebt.

Es mag anfangs komplex wirken, aber der erste Schritt zählt. Wenn du jetzt mit GEO und LLMO loslegst, sicherst du dir einen bedeutenden Vorsprung in einer zunehmend automatisierten und KI-getriebenen Welt. Und wie bei jeder erfolgreichen Strategie gilt: Kontinuierliche Anpassung und Verbesserung sind der Schlüssel. Bleib dran, und du wirst die Früchte deiner Arbeit in den kommenden Jahren ernten.

Die Zukunft gehört den Unternehmen, die in der Welt der KI-Antworten präsent sind. Mach den ersten Schritt, und stelle sicher, dass deine Marke nicht nur gefunden wird, sondern auch als vertrauenswürdige Quelle wahrgenommen wird.

Bereit, deine Content-Strategie für die neue Ära der KI-gesteuerten Antworten zu optimieren?

Wir helfen dir dabei, deine Sichtbarkeit in LLMs zu maximieren. Kontaktiere uns noch heute, um herauszufinden, wie du mit maßgeschneiderten Automationen und optimierten Content-Strategien erfolgreich durchstarten kannst.